Ewolucja metod badań UX dla agentów AI w zakresie współpracy w przedsiębiorstwach

\ Zmiana nastąpiła szybciej, niż ktokolwiek przewidział. Jednego dnia sztuczna inteligencja automatycznie uzupełniała nasze zdania. Następnego dołączała do naszych spotkań, podsumowywała nasze rozmowy i tworzyła wiadomości uzupełniające w naszym imieniu. Teraz podejmuje decyzje.

Spędziłem lata badając, jak zespoły współpracują za pośrednictwem inteligentnych platform, a to, czego jestem dziś świadkiem, stanowi najważniejszą transformację w dynamice miejsca pracy od czasu wprowadzenia poczty elektronicznej. Agenty AI nie są już narzędziami, których używamy. Są uczestnikami, z którymi współpracujemy.

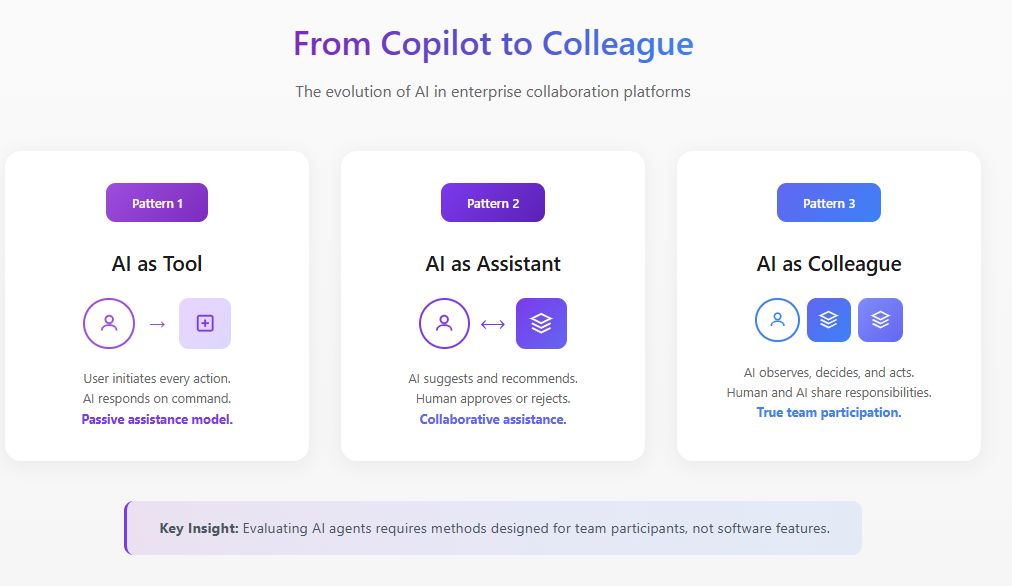

To rozróżnienie ma ogromne znaczenie dla badaczy UX. Metody, które opracowaliśmy do oceny funkcji oprogramowania, po prostu nie mają zastosowania, gdy to oprogramowanie zaczyna zachowywać się jak członek zespołu.

Fundamentalna zmiana: Od funkcji do uczestnika

Tradycyjne badania UX zadają pytania typu: Czy ta funkcja jest odkrywalna? Czy interakcja jest intuicyjna? Czy zmniejsza tarcie w przepływie pracy?

Te pytania zakładają, że AI jest pasywna, czekając na dane wejściowe użytkownika przed odpowiedzią. Ale agenty AI działają inaczej. Obserwują, interpretują, decydują i działają. Według badań MIT Sloan Management Review i Boston Consulting Group z 2025 roku, 35% organizacji już zaczęło korzystać z agentowej AI, a kolejne 44% planuje wkrótce ją wdrożyć. Jednak 47% wskazuje, że nie ma strategii dotyczącej tego, co zamierzają zrobić z AI. Ta luka między adopcją a zrozumieniem to dokładnie miejsce, w którym badania UX muszą wkroczyć.

Gdy agent AI dołącza do platformy współpracy, zmienia dynamikę społeczną zespołu. Wpływa na to, kto mówi, kiedy mówi i co czuje się komfortowo mówiąc. Ocena tych zmian wymaga metod, które wykraczają daleko poza testowanie użyteczności.

\

Wiodąca ocena AI dla platform współpracy przedsiębiorstw

W mojej pracy prowadzącej badania UX dla inteligentnych platform współpracy, opracowałem ramy oceny specjalnie zaprojektowane dla agentów AI działających w środowiskach przedsiębiorstw. Ta praca znajduje się na przecięciu strategii produktowej, rozwoju AI i badań czynników ludzkich.

Ocena AI w tym kontekście fundamentalnie różni się od tradycyjnego benchmarkingu modeli. Gdy agent AI działa w ramach platformy współpracy, nie możemy po prostu mierzyć dokładności czy jakości odpowiedzi w izolacji. Musimy ocenić, jak agent działa w złożonej dynamice społecznej i operacyjnej rzeczywistych zespołów.

Podchodzę do ocen AI dla współpracy przedsiębiorstw poprzez trzy wzajemnie połączone warstwy. Pierwsza warstwa bada wydajność funkcjonalną: czy agent poprawnie identyfikuje elementy działań, dokładnie podsumowuje dyskusje i przedstawia istotne informacje w odpowiednich momentach? Druga warstwa ocenia jakość integracji: jak płynnie agent działa w istniejących przepływach pracy bez tworzenia tarcia lub wymagania zmian behawioralnych od użytkowników? Trzecia warstwa, najczęściej pomijana, ocenia wpływ systemowy: jak obecność agenta wpływa na dynamikę zespołu, jakość decyzji i efektywność współpracy w czasie?

Badania Harvard Business Review z maja 2025 opisują agenty AI jako "cyfrowych współpracowników" reprezentujących wschodzącą kategorię talentów. To ujęcie wymaga, abyśmy oceniali agenty AI nie tylko pod kątem wykonania zadań, ale także tego, jak dobrze funkcjonują jako uczestnicy zespołu. Moje protokoły oceny obejmują obserwację behawioralną, śledzenie długoterminowe i analizę wyników, które tradycyjne benchmarki AI całkowicie pomijają.

Organizacje osiągające najsilniejsze wyniki to te, które bezpośrednio osadzają badania UX w swoich cyklach oceny AI, używając metryk skoncentrowanych na człowieku obok miar wydajności technicznej.

\

Budowanie hiperspersonalizowanych agentów AI poprzez strategiczne badania UX

Kolejną granicą dla platform współpracy przedsiębiorstw są hiperspersonalizowani agenci AI, którzy dostosowują się do indywidualnych użytkowników, kultur zespołów i kontekstów organizacyjnych. To tutaj badania UX stają się nie tylko oceniające, ale także generatywne, bezpośrednio kształtując sposób projektowania i wdrażania tych agentów.

Prowadziłem inicjatywy badawcze, które informują o strategicznym rozwoju spersonalizowanych agentów AI dla platform współpracy. Ta praca obejmuje zrozumienie konkretnych wzorców interakcji różnych typów użytkowników z AI, jak style komunikacji zespołowej różnią się w zależności od funkcji i geografii, oraz jak kultura organizacyjna wpływa na to, czego użytkownicy oczekują od asystenta AI.

Badania McKinsey z listopada 2025 na temat partnerstw AI zauważają, że realizacja potencjału AI wymaga przeprojektowania przepływów pracy, aby ludzie, agenci i roboty współpracowali efektywnie. Z perspektywy strategii produktowej oznacza to, że agenci AI nie mogą być uniwersalni. Muszą dostosować swój styl komunikacji, częstotliwość interwencji i poziom autonomii w oparciu o preferencje użytkownika i czynniki kontekstowe.

Moje badania zidentyfikowały kilka wymiarów personalizacji, które mają największe znaczenie w kontekstach współpracy przedsiębiorstw. Dopasowanie stylu komunikacji zapewnia, że agent odzwierciedla sposób, w jaki użytkownicy naturalnie wyrażają siebie, czy to formalny czy swobodny, szczegółowy czy zwięzły. Kalibracja czasu interwencji uczy się, kiedy poszczególni użytkownicy preferują proaktywną pomoc, a kiedy chcą pracować bez przerywania. Dostosowanie progu zaufania rozpoznaje, że różni użytkownicy mają różne poziomy komfortu z autonomią AI i kalibruje się odpowiednio.

Implikacje strategiczne są znaczące. Zespoły produktowe budujące agentów AI dla platform współpracy potrzebują ciągłego wkładu badań UX, aby zrozumieć, jak funkcje personalizacji działają w różnorodnych populacjach użytkowników. Bez tej podstawy badawczej wysiłki personalizacyjne ryzykują tworzenie agentów, którzy wydają się inwazyjni dla jednych użytkowników, a bezużyteczni dla innych.

Ramy oceny agentów AI w środowiskach współpracy

Poprzez rozległe badania terenowe z interdyscyplinarnymi zespołami wdrażającymi agentów AI w swoich przepływach pracy współpracy, opracowałem ramy oceny zbudowane wokół czterech wymiarów, które tradycyjne metody pomijają.

- Wpływ obecności bada, jak obecność agenta AI zmienia zachowanie zespołu, niezależnie od jego funkcjonalnych wkładów. Zaobserwowałem, że zespoły stają się mierzalnie bardziej formalne, gdy wiedzą, że AI dokumentuje ich rozmowy. Dyskusje poboczne maleją. Myślenie eksploracyjne zostaje zastąpione bezpieczniejszymi wkładami.

- Granice agencji określają, gdzie powinna się zaczynać i kończyć autonomia agenta AI oraz jak zespoły negocjują te granice. Wytyczne Światowego Forum Ekonomicznego z 2025 roku dotyczące agentów AI podkreślają, że zarządzanie musi promować przejrzystość poprzez ciągłe monitorowanie. W moich badaniach odkryłem, że deklarowane preferencje dotyczące autonomii AI rzadko odpowiadają ujawnionym preferencjom. Zespoły często mówią, że chcą, aby agenci AI wykazywali więcej inicjatywy, ale opierają się, gdy agenci faktycznie to robią.

- Kalibracja zaufania koncentruje się na tym, jak zespoły rozwijają odpowiednie zaufanie, unikając zarówno nadmiernego polegania, jak i niedostatecznego wykorzystania. Agent AI, który popełnia jeden znaczący błąd, może zniszczyć miesiące budowania zaufania, podczas gdy agent, który działa perfekcyjnie, może stworzyć niebezpieczne samozadowolenie.

- Integracja współpracy bada, jak agent AI wpływa na dynamikę zespołu, przepływ informacji i zbiorową inteligencję. Czy agent AI pomaga zespołowi podejmować lepsze decyzje, czy tworzy iluzję dokładności maskującą płytkie myślenie?

Studium przypadku: Rekonfiguracja zakresu agenta AI

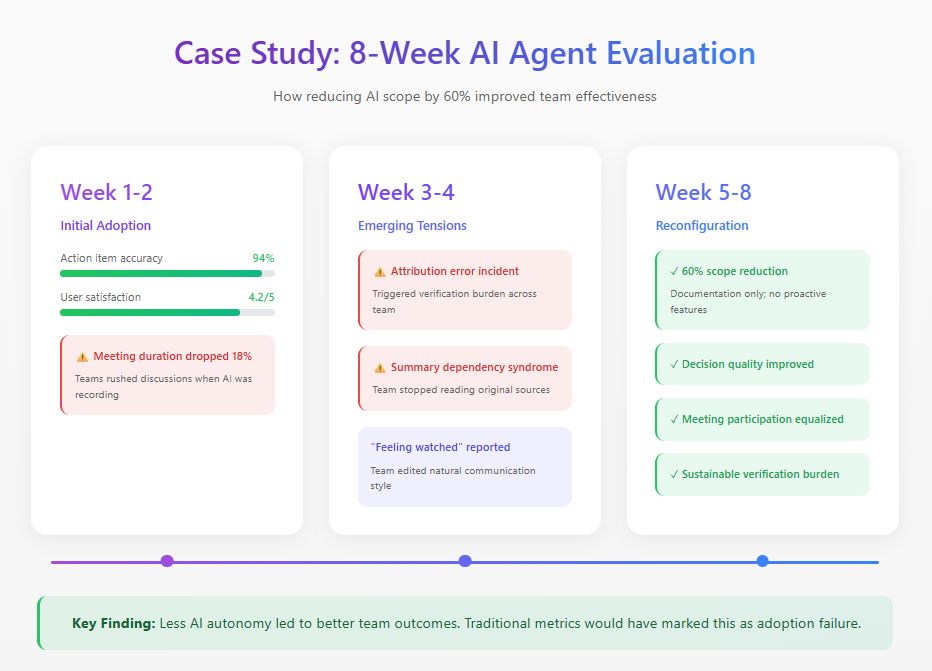

Niedawno przeprowadziłem ośmiotygodniowe badanie z rozproszonym zespołem produktowym wdrażającym agenta AI w swojej platformie współpracy. Agent został zaprojektowany do uczestniczenia w spotkaniach, generowania podsumowań, śledzenia decyzji i proaktywnego przedstawiania istotnych informacji.

Początkowe metryki wyglądały doskonale: 94% dokładności elementów działań, oceny satysfakcji 4,2 na 5. Ale obserwacja behawioralna ujawniła problemy niewidoczne dla dashboardów. Czas trwania spotkań spadł o 18%, ponieważ członkowie zespołu przyspieszali dyskusje, świadomi, że każde słowo jest rejestrowane. Do trzeciego tygodnia błąd przypisania wywołał obciążenie weryfikacyjne, które pochłaniało więcej czasu niż dokumentacja, którą zastąpiło. Członkowie zespołu rozwinęli również to, co nazywam "syndromem zależności od podsumowań", polegając wyłącznie na podsumowaniach AI i pomijając kluczowy kontekst.

Na podstawie tych ustaleń zespół przekonfigurował agenta AI, zmniejszając jego zakres funkcjonalny o 60%. Usunęli proaktywne funkcje, zachowując zadania dokumentacyjne, gdzie dokładność była wysoka. Tradycyjne metryki adopcji oznaczyłyby to jako porażkę. Ale miary efektywności zespołu opowiedziały inną historię: jakość decyzji poprawiła się, uczestnictwo w spotkaniach stało się bardziej sprawiedliwe, a obciążenie weryfikacyjne spadło do zrównoważonych poziomów.

Najważniejsze ustalenie wyłoniło się z wywiadów. Wielu członków zespołu opisało uczucie bycia "obserwowanym" podczas fazy pełnej autonomii. Ten mrożący efekt na autentyczną komunikację nigdy nie pojawił się w żadnej metryce dashboardu.

\

\

Praktyczne metody oceny

Na podstawie tych badań i podobnych studiów, zalecam następujące metody oceny agentów AI w środowiskach współpracy.

- Obserwacja długoterminowa wymaga minimum sześciotygodniowych okresów obserwacji z ustaleniem linii bazowej przed wprowadzeniem agenta AI. Jednosesyjne testy użyteczności nie ujawniają prawie nic użytecznego o dynamice współpracy AI.

- Analiza wzorców komunikacji obejmuje ilościowe śledzenie tego, kto mówi, jak często i w jakich kontekstach w fazach przed wdrożeniem, wczesnego wdrożenia i dojrzałego wdrożenia.

- Ocena kalibracji zaufania regularnie mierzy, jak zaufanie członków zespołu do możliwości AI porównuje się z rzeczywistą wydajnością AI.

- Audyty jakości decyzji zapewniają retrospektywną analizę decyzji podejmowanych z udziałem agenta AI, śledząc wyniki i identyfikując, gdzie wkład AI pomógł lub przeszkodził.

Droga naprzód

Agenty AI staną się wszechobecne we współpracy przedsiębiorstw. Pytanie badawcze nie dotyczy tego, czy organizacje je przyjmą, ale jak skutecznie je zintegrują.

Badacze UX mają kluczową rolę w kształtowaniu tej integracji. Posiadamy metody do zrozumienia ludzkiego zachowania i ramy do oceny jakości doświadczenia. Organizacje, które zrobią to dobrze, zbudują systemy współpracy, w których ludzie i agenty AI naprawdę się uzupełniają. Te, które traktują agenty AI jako kolejną funkcję, odkryją, że ich zespoły pracują mniej efektywnie niż przed pojawieniem się technologii.

\

Możesz także polubić

Analiza Bitcoin: Korekta fali 4 na poziomie 83 tys. USD sygnalizuje potencjalny wzrost do 127 tys. USD

Wiadomości Bitcoin: Chiński zakaz wydobycia zwiększa presję, gdy cena BTC gwałtownie spada