Evolutie van UX-onderzoeksmethoden voor AI-agenten in bedrijfssamenwerking

\ De verschuiving gebeurde sneller dan iemand had voorspeld. De ene dag vulde AI onze zinnen aan. De volgende dag nam het deel aan onze vergaderingen, vatte onze gesprekken samen en stelde namens ons follow-upberichten op. Nu neemt het beslissingen.

Ik heb jarenlang onderzoek gedaan naar hoe teams samenwerken via intelligente platforms, en wat ik vandaag zie, vertegenwoordigt de belangrijkste transformatie in werkplaatsdynamiek sinds de introductie van e-mail. AI-agenten zijn niet langer hulpmiddelen die we gebruiken. Ze zijn deelnemers waarmee we samenwerken.

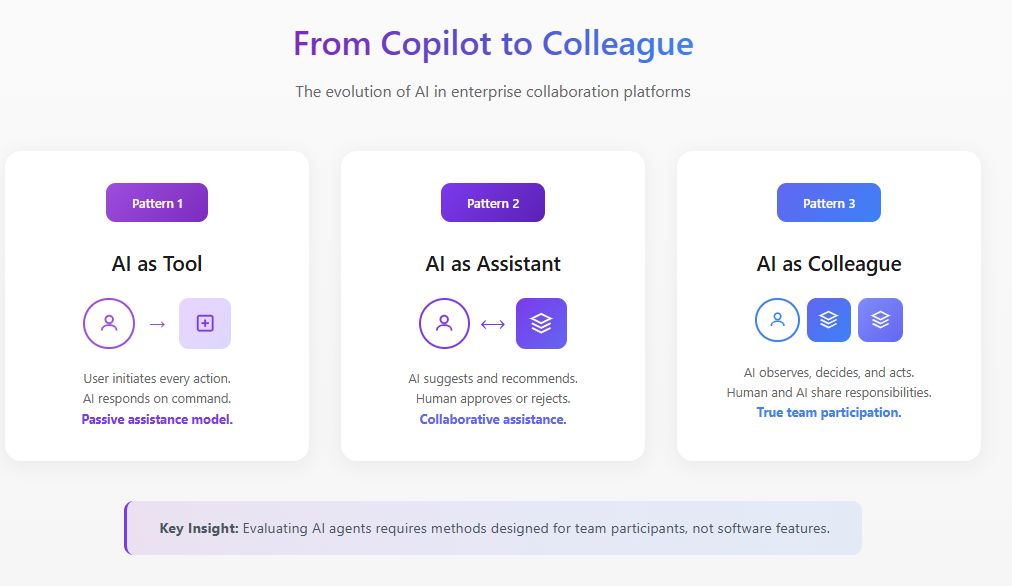

Dit onderscheid is enorm belangrijk voor UX-onderzoekers. De methoden die we hebben ontwikkeld om softwarefuncties te evalueren, zijn simpelweg niet van toepassing wanneer die software zich begint te gedragen als een teamlid.

De Fundamentele Verschuiving: Van Functie naar Deelnemer

Traditioneel UX-onderzoek stelt vragen zoals: Is deze functie vindbaar? Is de interactie intuïtief? Vermindert het wrijving in de workflow?

Deze vragen gaan ervan uit dat de AI passief is en wacht op gebruikersinvoer voordat het reageert. Maar AI-agenten werken anders. Ze observeren, interpreteren, beslissen en handelen. Volgens onderzoek uit 2025 van MIT Sloan Management Review en Boston Consulting Group is 35% van de organisaties al begonnen met het gebruik van agentische AI, terwijl nog eens 44% van plan is het binnenkort te implementeren. Toch geeft 47% aan geen strategie te hebben voor wat ze met AI gaan doen. Deze kloof tussen adoptie en begrip is precies waar UX-onderzoek moet ingrijpen.

Wanneer een AI-agent zich aansluit bij een samenwerkingsplatform, verandert het de sociale dynamiek van het team. Het beïnvloedt wie spreekt, wanneer ze spreken en wat ze comfortabel vinden om te zeggen. Het evalueren van deze verschuivingen vereist methoden die veel verder gaan dan bruikbaarheidstests.

\

Leidende AI-evaluatie voor Enterprise Samenwerkingsplatforms

In mijn werk als leider van UX-onderzoek voor intelligente samenwerkingsplatforms heb ik evaluatiekaders ontwikkeld die specifiek zijn ontworpen voor AI-agenten die in bedrijfsomgevingen opereren. Dit werk bevindt zich op het snijvlak van productstrategie, AI-ontwikkeling en onderzoek naar menselijke factoren.

AI-evaluatie in deze context is fundamenteel anders dan traditionele modelbenchmarking. Wanneer een AI-agent binnen een samenwerkingsplatform opereert, kunnen we niet simpelweg nauwkeurigheid of responskwaliteit geïsoleerd meten. We moeten evalueren hoe de agent presteert binnen de complexe sociale en operationele dynamiek van echte teams.

Ik benader AI-evaluaties voor bedrijfssamenwerking via drie onderling verbonden lagen. De eerste laag onderzoekt functionele prestaties: identificeert de agent correct actiepunten, vat het discussies nauwkeurig samen en brengt het relevante informatie op gepaste momenten naar voren? De tweede laag beoordeelt integratiekwaliteit: hoe naadloos opereert de agent binnen bestaande workflows zonder wrijving te creëren of gedragsveranderingen van gebruikers te vereisen? De derde laag, en degene die het vaakst over het hoofd wordt gezien, evalueert systemische impact: hoe beïnvloedt de aanwezigheid van de agent de teamdynamiek, besluitkwaliteit en samenwerkingseffectiviteit op lange termijn?

Harvard Business Review-onderzoek van mei 2025 beschrijft AI-agenten als "digitale teamgenoten" die een opkomende categorie talent vertegenwoordigen. Deze formulering vereist dat we AI-agenten niet alleen evalueren op taakuitvoering, maar ook op hoe goed ze functioneren als teamdeelnemers. Mijn evaluatieprotocollen omvatten gedragsobservatie, longitudinale tracking en uitkomstanalyse die traditionele AI-benchmarks volledig missen.

De organisaties die de sterkste resultaten behalen, zijn degenen die UX-onderzoek direct in hun AI-evaluatiecycli integreren, waarbij ze mensgerichte metrieken naast technische prestatiemetingen gebruiken.

\

Het Bouwen van Hyper-gepersonaliseerde AI-agenten Door Strategisch UX-onderzoek

De volgende grens voor enterprise samenwerkingsplatforms zijn hyper-gepersonaliseerde AI-agenten die zich aanpassen aan individuele gebruikers, teamculturen en organisatorische contexten. Dit is waar UX-onderzoek niet alleen evaluatief wordt maar ook generatief, direct vormgevend aan hoe deze agenten worden ontworpen en ingezet.

Ik heb onderzoeksinitiatieven geleid die de strategische ontwikkeling van gepersonaliseerde AI-agenten voor samenwerkingsplatforms informeren. Dit werk omvat het begrijpen van de specifieke patronen van hoe verschillende gebruikerstypen met AI interacteren, hoe teamcommunicatiestijlen variëren tussen functies en geografieën, en hoe organisatiecultuur beïnvloedt wat gebruikers verwachten van AI-assistentie.

McKinsey's onderzoek van november 2025 over AI-partnerschappen merkt op dat het realiseren van AI's potentieel het herontwerpen van workflows vereist zodat mensen, agenten en robots effectief samenwerken. Vanuit een productstrategieperspectief betekent dit dat AI-agenten niet one-size-fits-all kunnen zijn. Ze moeten hun communicatiestijl, interventiefrequentie en autonomieniveau aanpassen op basis van gebruikersvoorkeuren en contextuele factoren.

Mijn onderzoek heeft verschillende personalisatiedimensies geïdentificeerd die het belangrijkst zijn in enterprise samenwerkingscontexten. Communicatiestijl matching zorgt ervoor dat de agent weerspiegelt hoe gebruikers zich natuurlijk uitdrukken, of dat nu formeel of casual is, gedetailleerd of beknopt. Interventietiming kalibratie leert wanneer individuele gebruikers proactieve assistentie prefereren versus wanneer ze ononderbroken willen werken. Vertrouwensdrempel aanpassing erkent dat verschillende gebruikers verschillende comfortniveaus hebben met AI-autonomie en kalibreert dienovereenkomstig.

De strategische implicaties zijn significant. Productteams die AI-agenten bouwen voor samenwerkingsplatforms hebben continue UX-onderzoeksinput nodig om te begrijpen hoe personalisatiefuncties presteren bij diverse gebruikerspopulaties. Zonder deze onderzoeksbasis riskeren personalisatie-inspanningen het creëren van agenten die voor sommige gebruikers opdringerig aanvoelen terwijl ze voor anderen niet behulpzaam lijken.

Een Kader voor het Evalueren van AI-agenten in Samenwerkingsomgevingen

Door uitgebreid veldonderzoek met cross-functionele teams die AI-agenten adopteren in hun samenwerkingsworkflows, heb ik een evaluatiekader ontwikkeld rond vier dimensies die traditionele methoden over het hoofd zien.

- Aanwezigheidsimpact onderzoekt hoe de aanwezigheid van de AI-agent teamgedrag verandert, onafhankelijk van zijn functionele bijdragen. Ik heb geobserveerd dat teams meetbaar formeler worden wanneer ze weten dat een AI hun gesprekken documenteert. Zijdelingse discussies nemen af. Verkennend denken wordt vervangen door veiligere bijdragen.

- Agentschapsgrenzen behandelt waar de autonomie van de AI-agent moet beginnen en eindigen, en hoe teams deze grenzen onderhandelen. De World Economic Forum's 2025-richtlijnen voor AI-agenten benadrukken dat governance transparantie moet bevorderen door continue monitoring. In mijn onderzoek heb ik ontdekt dat uitgesproken voorkeuren voor AI-autonomie zelden overeenkomen met geopenbaarde voorkeuren. Teams zeggen vaak dat ze willen dat AI-agenten meer initiatief nemen, maar verzetten zich wanneer agenten dit daadwerkelijk doen.

- Vertrouwenskalibratie richt zich op hoe teams passend vertrouwen ontwikkelen, waarbij zowel overmatige afhankelijkheid als onderbenutting worden vermeden. Een AI-agent die één significante fout maakt, kan maanden van vertrouwensopbouw vernietigen, terwijl een agent die perfect presteert gevaarlijke zelfgenoegzaamheid kan creëren.

- Samenwerkingsintegratie onderzoekt hoe de AI-agent teamdynamiek, informatiestromen en collectieve intelligentie beïnvloedt. Helpt de AI-agent het team betere beslissingen te nemen, of creëert het een illusie van grondigheid die oppervlakkig denken maskeert?

Casestudy: Het Herconfigureren van AI-agent Bereik

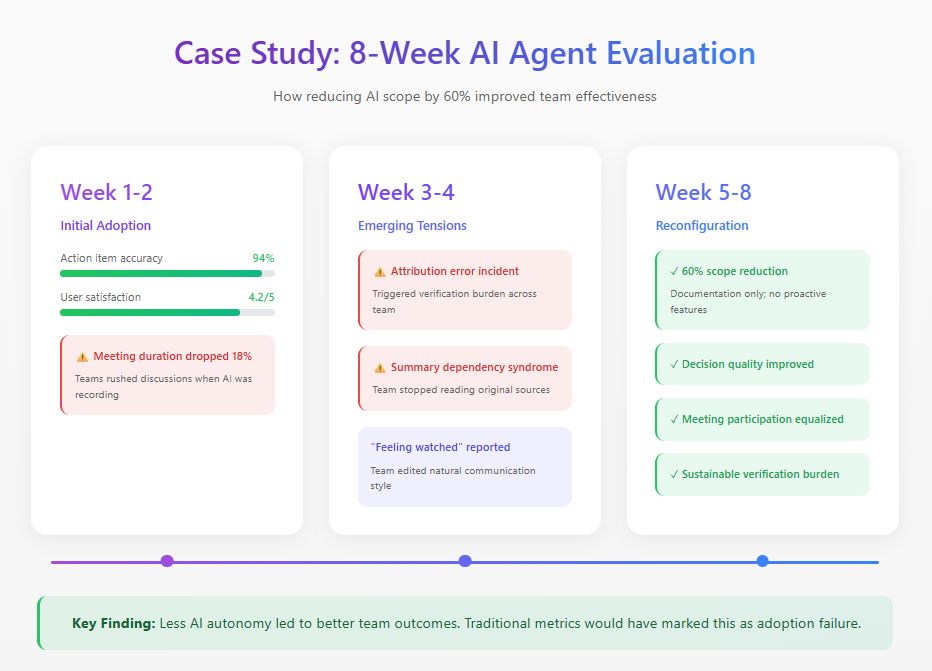

Ik heb onlangs een acht weken durende studie uitgevoerd met een gedistribueerd productteam dat een AI-agent implementeerde op hun samenwerkingsplatform. De agent was ontworpen om vergaderingen bij te wonen, samenvattingen te genereren, beslissingen te volgen en proactief relevante informatie naar boven te halen.

Initiële metrieken zagen er uitstekend uit: 94% nauwkeurigheid van actiepunten, 4,2 uit 5 tevredenheidsbeoordelingen. Maar gedragsobservatie onthulde problemen die onzichtbaar waren voor dashboards. Vergaderingsduur daalde met 18% omdat teamleden discussies haastten, zich bewust dat elk woord werd vastgelegd. Tegen week drie veroorzaakte een attributiefout een verificatielast die meer tijd kostte dan de documentatie die het verving. Teamleden ontwikkelden ook wat ik "samenvattingsafhankelijkheidssyndroom" noem, waarbij ze uitsluitend vertrouwden op AI-samenvattingen en cruciale context misten.

Op basis van deze bevindingen herconfigureerde het team de AI-agent, waarbij ze het functionele bereik met 60% verminderden. Ze verwijderden proactieve functies terwijl ze documentatietaken behielden waar de nauwkeurigheid hoog was. Traditionele adoptiemetrieken zouden dit als mislukking bestempelen. Maar teameffectiviteitsmetingen vertelden een ander verhaal: besluitkwaliteit verbeterde, vergaderingsparticipatie werd gelijkwaardiger, en de verificatielast daalde naar duurzame niveaus.

De belangrijkste bevinding kwam uit interviews. Meerdere teamleden beschreven een gevoel van "bekeken worden" tijdens de volledige-autonomiefase. Dit verkillende effect op authentieke communicatie verscheen nooit in enige dashboardmetriek.

\

\

Praktische Evaluatiemethoden

Op basis van dit onderzoek en vergelijkbare studies, beveel ik de volgende methoden aan voor het evalueren van AI-agenten in samenwerkingsomgevingen.

- Longitudinale Observatie vereist minimaal zes weken observatieperiodes met basislijnvaststelling vóór AI-agent introductie. Enkelsessie bruikbaarheidstests onthullen bijna niets nuttigs over collaboratieve AI-dynamiek.

- Communicatiepatroonanalyse omvat kwantitatieve tracking van wie spreekt, hoe vaak, en in welke contexten over pre-deployment, vroege deployment, en volwassen deployment fases.

- Vertrouwenskalibratiebeoordeling meet regelmatig hoe het vertrouwen van teamleden in AI-capaciteiten zich verhoudt tot de werkelijke AI-prestaties.

- Besluitkwaliteitsaudits bieden retrospectieve analyse van beslissingen genomen met AI-agent betrokkenheid, het volgen van uitkomsten en identificeren waar AI-bijdrage hielp of hinderde.

De Weg Vooruit

AI-agenten zullen alomtegenwoordig worden in bedrijfssamenwerking. De onderzoeksvraag is niet of organisaties ze zullen adopteren, maar hoe ze ze effectief zullen integreren.

UX-onderzoekers hebben een cruciale rol in het vormgeven van deze integratie. We bezitten de methoden om menselijk gedrag te begrijpen en de kaders om ervaringskwaliteit te evalueren. De organisaties die dit goed doen, zullen samenwerkingssystemen bouwen waar mensen en AI-agenten elkaar echt aanvullen. Degenen die AI-agenten behandelen als slechts een andere functie zullen ontdekken dat hun teams minder effectief werken dan voordat de technologie arriveerde.

\

Misschien vind je dit ook leuk

Animoca Werkt Samen met GROW om Crypto en Traditionele Financiën te Verbinden

BNB Chain: Exponentiële Groei van Activiteit, Tokens en DeFi in Messari-rapport